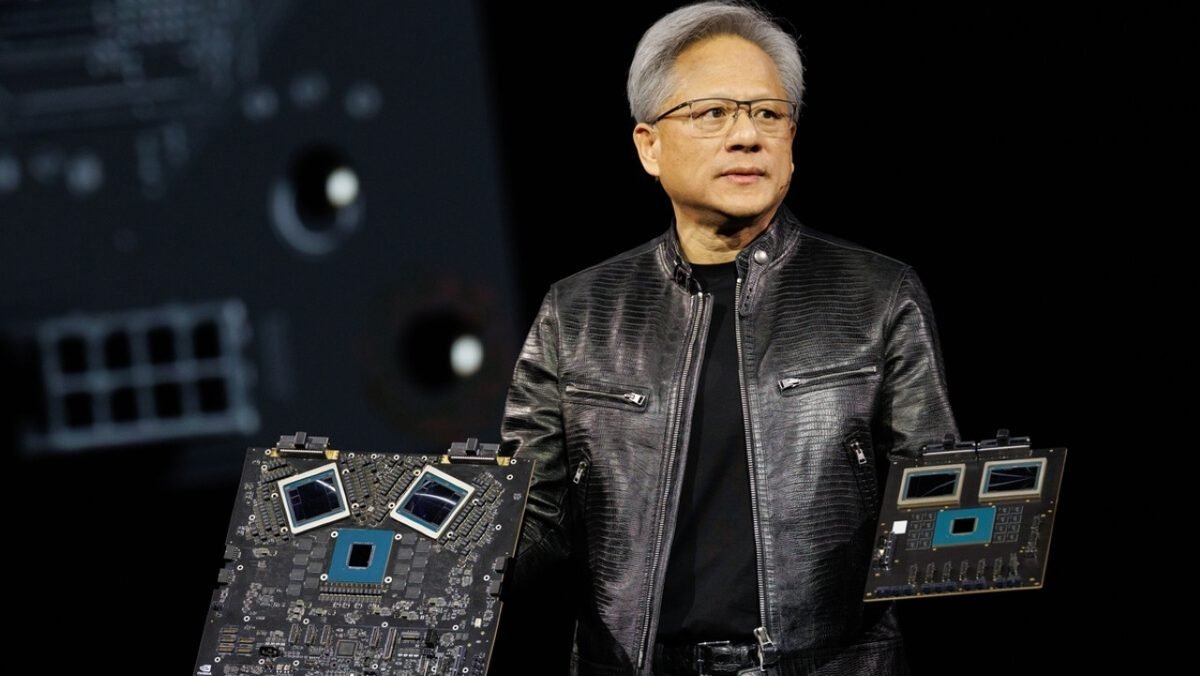

A Nvidia, sob a liderança de Jensen Huang, recentemente impressionou o mercado com a revelação de seus novos chips de Inteligência Artificial (IA), a inovadora arquitetura Blackwell e, em particular, o poderoso acelerador GB200. No entanto, o que realmente capturou a atenção do mundo tecnológico foi a criação de um verdadeiro gigante computacional: o servidor de IA DGX GB200 NVL72. Esta máquina impressionante não apenas estabelece novos marcos em poder de processamento, mas também desafia os limites da engenharia, apresentando uma quantidade surpreendente de fiação interna.

Projetado para revolucionar o campo da IA e o treinamento de modelos massivos, este supercomputador combina 36 aceleradores GB200. Cada um desses aceleradores é equipado com uma CPU NVIDIA Grace de 72 núcleos ARM Neoverse V2 e duas GPUs B200. Juntos, esses componentes liberam uma potência combinada de incríveis 1,44 exaFLOPS na precisão FP4, um feito tecnológico que redefine os limites do poder computacional em larga escala.

A Arquitetura Massiva do DGX GB200 NVL72

O DGX GB200 NVL72, embora se apresente em um formato estreito, é extraordinariamente denso, pesando impressionantes 1,36 tonelada. Internamente, ele abriga 18 nós de computação no formato 1U, cada um contendo duas GB200s, totalizando 72 GPUs B200 dedicadas à IA. O custo estimado deste servidor de IA atinge a marca dos US$ 3 milhões, posicionando-o como uma das máquinas mais caras e potentes já construídas para a era da inteligência artificial.

A vasta quantidade de calor gerado por esses componentes de alta performance exige uma solução de resfriamento líquido altamente eficiente. Este sistema abrange não apenas as CPUs Grace e as GPUs B200, mas também os chips NVLink presentes nos switches, que se aquecem significativamente devido à transferência massiva de dados entre os aceleradores, garantindo a estabilidade e o desempenho contínuo do sistema.

Interconexões e os Surpreendentes 3 KM de Cabos de Cobre

Para que todas as 72 GPUs B200 operem em sincronia perfeita e com máxima eficiência, cada um dos 36 aceleradores GB200 incorpora placas de rede especializadas com suporte à quinta geração do NVLink. Essa tecnologia permite que cada nó de computação esteja interconectado aos demais, garantindo uma largura de banda bidirecional impressionante de 1,8 TB/s entre todas as GPUs do servidor. Para viabilizar essa vasta rede de interconexões, nove switches de alta capacidade são responsáveis por gerenciar o fluxo de dados.

Contudo, o aspecto mais surpreendente, conforme apontado pelo The Register, é a quantidade de fiação interna: um total de 3,2 quilômetros de cabo de cobre estão contidos dentro deste supercomputador Nvidia. Para ilustrar a escala, apenas o módulo que contém os switches pesa mais de 30 quilos, resultado da complexidade desses componentes e dos mais de 5.000 cabos necessários para manter todo o sistema funcionando em perfeita harmonia e desempenho.

Por Que Cabos de Cobre em Vez de Fibra Óptica?

A escolha pelo cabo de cobre pode parecer contraintuitiva, especialmente considerando os requisitos de altíssima largura de banda desta máquina. No entanto, a solução com cabo de fibra óptica apresentaria desafios significativos. Ela exigiria o uso de componentes eletrônicos adicionais para estabilizar e converter os sinais ópticos, o que não só elevaria drasticamente o custo de produção, mas também aumentaria consideravelmente o consumo de energia do sistema final. Assim, a decisão pelo cobre foi uma estratégia inteligente da Nvidia, buscando o equilíbrio ideal entre desempenho, custo e eficiência energética para um projeto dessa magnitude.

Poder Além dos Games: O Propósito do DGX GB200 NVL72

O desempenho individual de cada chip B200 já é notável por si só, superando em três vezes a potência de uma placa de vídeo de consumo como a GeForce RTX 5090. Considerando que o servidor completo inclui 72 dessas GPUs especializadas em IA, o poder computacional do DGX GB200 NVL72 é verdadeiramente colossal e sem precedentes. Embora esses chips contem com núcleos RT (ray tracing) de quarta geração, o que teoricamente permitiria seu uso em jogos, é crucial ressaltar que esse não é, nem de longe, o propósito principal dessas máquinas. Na verdade, seu desempenho em games provavelmente seria inferior ao de uma Nvidia H100, pois são intrinsecamente otimizadas para tarefas complexas de IA e processamento de dados massivos.

Apesar de os novos chips Blackwell serem significativamente mais eficientes que a geração anterior H100, este servidor de IA ainda possui um TDP (Thermal Design Power) estimado de 140 kW. Para contextualizar a demanda energética dessas máquinas de ponta: uma residência média no Brasil consome cerca de 3.000 kWh por ano. Isso significa que, em apenas uma hora de uso, o supercomputador Nvidia consome praticamente a mesma quantidade de energia que uma residência média consome em 17 dias. Mantê-lo funcionando o ano todo resultaria em um consumo similar ao de 415 residências médias ao longo do mesmo período. Esses dados impressionantes ressaltam o imenso poder e a demanda energética das infraestruturas de IA que estão moldando o futuro tecnológico global.

Confira um vídeo sobre a arquitetura Blackwell:

Interessado no futuro da Inteligência Artificial? Descubra como o DGX GB200 NVL72 da Nvidia está impulsionando a próxima geração de inovações e deixe seu comentário abaixo sobre o impacto dessas supermáquinas!